AI利用におけるプライバシー

地田 圭太 日立コンサルティング シニアコンサルタント

佐武 史啓 日立コンサルティング コンサルタント

2020年7月31日

はじめに

近年、AIをはじめとするITの発展により、パーソナルデータを利用した新たなサービスが次々と生み出され、私たちの生活に大きな影響を与えつつあります。その一方で、技術に起因する、予期せぬプライバシー侵害が問題となっており、その対策に関する議論も活発化しています。

本稿では、AIを用いたパーソナルデータの利用において考慮すべきプライバシー侵害のリスクを整理した上で、その対策となるルールや技術について紹介します。

1. AIの利用におけるプライバシー侵害のリスク

まずはAI利用の流れを見てみましょう。AIだからといって特殊なわけではなく、大きく「収集・集積」「解析」「利用」という一連の流れにより成り立つと考えられます。まずは、パーソナルデータを「収集・集積」する必要があります。次に、収集・集積したデータをAIにより「解析」することでパターンや相関関係を導き出します。これにより、例えば個人の趣味嗜(し)好、健康状態、信用力などを推測する「プロファイリング」が可能となります。最後に、解析結果を何らかの目的に「利用」します。例えば、Webサイトの閲覧履歴を解析することでその人が購入する可能性が高い商品を推測し、それに応じた広告を表示するといった具合です。

AIを用いたデータ解析の大きな特徴は、従来の技術では解析が難しかったデータの処理が可能になること、処理が自動化されて人手による作業が介在しなくなること、そして、処理の過程のブラックボックス化などです。こうした状況下、AIを用いない従来のデータ解析では意識されなかった、新たなプライバシー侵害のリスクが現れてきています。

次に、この一連の流れの中でどこにどのようなリスクがあるのかを網羅的に整理するために、プライバシー侵害のリスクを類型化します。

プライバシーの侵害行為の様態を分類したものとして、1960年にウィリアム・L・プロッサーが論文 『Privacy』の中で示した、通称「プロッサーの4類型」があります。プロッサーは、プライバシーの侵害行為を以下の4つに分類し、それぞれ異なる利益の侵害であるとしました。

- 一人で他人から隔絶されて送っている私的な生活へ侵入する(私生活への侵入)

- 知られたくない私的な事実を公開する(私生活の公開)

- 一般の人に誤った印象を与えるような事実を公表する(誤認を生ずる表現)

- 肖像を、他人が利得のために流用する(私事の営利的利用)

ただし、この考えが示されたのは今から60年前であり、社会環境の変化に伴ってプライバシーの概念も変化してきています。プロッサーの4類型にない新たなプライバシーの考え方として「プライバシーの権利は『自己に関する情報に対するコントロール権』である」というものがあります。近年では例えば、2018年5月に施行されたGDPR※1は、データの主体である個人がデータの管理者に対して自身のパーソナルデータの訂正や削除、移動を求める権利を保障しているといった点で、自己情報コントロール権の確保に重きを置いた内容となっています。このように、自己情報コントロール権の考え方は一般的なものとして浸透してきています。そこでここでは、プロッサーの4類型に以下の1項目を加え、プライバシー侵害のリスクを5類型化します。

- 自身の情報の訂正、削除、移動、開示を求めることができない (自己情報コントロール権の欠落)

- ※1

- GDPR(General Data Protection Regulation): 一般データ保護規則

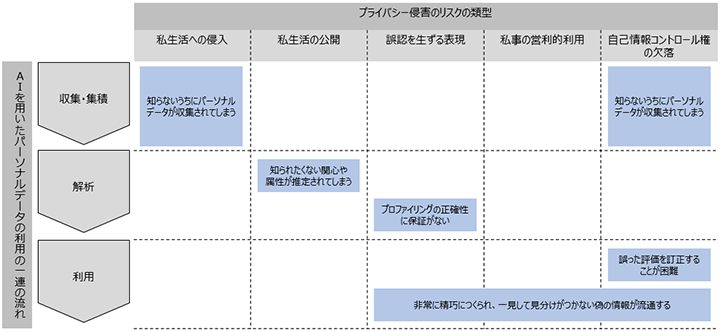

図1はAIを用いたパーソナルデータ利用一連の流れの中で、問題となっているプライバシー侵害のリスクを、報道されている事例や文献等の調査をもとに、5類型毎に整理したものです。

図1.AIの利用におけるプライバシー侵害のリスク

図1で整理した各プライバシー侵害のリスクがどのようなものか、実例を交えながら説明します。

(1) 知らないうちにパーソナルデータが収集されてしまう

AIによる解析には大量のデータの収集・集積が不可欠ですが、収集されるデータの種類やその収集方法も多様化しています。これには、大きく2つの理由があります。第1に、AIによる解析技術の発達により、多様なパーソナルデータをもとに個人をプロファイリングできるようになったことで、解析のために収集されるデータの種類が増加しているという理由、第2に、各種センサー技術の発達により、従来であれば収集することが難しかったデータを収集し、そこから解析に有用なデータを抽出することが容易になってきているという理由です。

一方、身の回りのさまざまなデータがAIによる解析の対象となることに不快感を覚える人もいます。例えば2017年3月、札幌市は、当初計画していたカメラ画像解析の実証実験を中止することを発表しました※2。実証実験は、カメラで撮影された人の顔の特徴を解析することで性別や年齢を識別し、その結果に応じた電子看板広告の切り替えを想定したものでしたが、市民からプライバシーの侵害や個人情報の流出を不安視する声が多数寄せられたことを受け、実施を見送るに至ったようです。

パーソナルデータを収集する際には、本人にその旨を説明し、場合によっては同意を得る必要があります。しかし、収集するデータの種類やその収集方法が多様化することにより、本人が気づかないうちにパーソナルデータを収集されてしまうというプライバシー侵害のリスクが大きくなっています。

- ※2

- “札幌市「顔認証」実験中止 プライバシーや個人情報流出に不安の声”(北海道新聞、2017年3月23日)

(2) 知られたくない関心や属性が推定されてしまう

AIによるプロファイリングがプライバシー侵害となりえることを示す事例として、米国小売業大手のターゲット社でのエピソードがあげられます。ニューヨークタイムズ社の記事※3によると、ターゲット社は顧客の購買傾向をもとに、購入の見込みが高い商品を推測しレコメンデーションを行っていましたが、あるとき、高校生の娘に対して妊娠に関連した商品がレコメンドされたとして、その父親からクレームがあったといいます。マネジャーは謝罪し、数日後に再び謝罪するために父親に電話をしました。しかし実際にはプロファイリングが合っており、娘は出産予定であることが判明し、父親がターゲット社に対して逆に謝罪することになりました。

この事例のように、AIによるプロファイリングは、それ自体はセンシティブといえない情報から、極めてセンシティブな情報を導き出す可能性があります。政治的な信条や健康状態などセンシティブな情報を導き出すプロファイリングは、知られたくない情報が知られてしまう可能性があるという点でプライバシー侵害のリスクが高いと言えます。

- ※3

- “How Companies Learn Your Secrets” (CHARLES DUHIGG著、2012年2月16日)

(3) プロファイリングの正確性に保証がない

プロファイリングにはエラーやバイアスが紛れ込むことがあり、正確性が保証されているわけではありません。

米国ではウィスコンシン州をはじめいくつかの州において、裁判所の量刑判断といった場面でCOMPASという再犯リスク評価システムを用いています。これは、犯罪歴、雇用状況、教育レベルなどについて被告に質問し、その回答から再犯リスクを推測するというものです。このCOMPASの精度について、米調査報道メディアのプロパブリカが独自に検証を行い、その結果を発表※4しています。それによると、プロパブリカが2013年から2014年にフロリダ州ブロワード郡で逮捕された7,000人以上のCOMPASによる再犯リスクの評価を取得し、2年間にそのうち何人が新たな犯罪で起訴されたかを調査したところ、白人の被告は再犯リスクが低く、逆に、黒人の被告は再犯リスクが高く評価される傾向があることが分かりました。再犯リスクの評価後2年間再犯のなかった人物が、再犯リスクが高いと評価されていた割合は、白人が23.5%、黒人が44.9%と約1.9倍の差がありました。また、再犯リスクの評価後、2年以内に再犯した人物が、再犯リスクが低いと評価されていた割合も、白人が47.7%、黒人が28.0%と約1.7倍の差がありました。

プロファイリングはあくまで確率的な評価に過ぎません。特にこの事例のように、個人の人生に大きな影響を与えるような重大な判断の材料に、プロファイリング結果を用いる場合は、その点に十分留意する必要があります。

また、解析の対象となるデータが母集団の実態に即しておらず、本来は無関係なパターンや相関関係がアルゴリズムに組み込まれてしまう、現実世界にある差別や偏見がアルゴリズムに反映されてしまうといったことにより、プロファイリングのアルゴリズムそのものの正確性が損なわれてしまう可能性もあります。

正確性が保証されていないプロファイリング結果に基づいて個人を評価することは、本人に関して誤った印象を与えてしまう可能性があるという点で、プライバシー侵害のリスクがあると言えます。

- ※4

- “Machine Bias There's software used across the country to predict future criminals. And it's biased against blacks. ”(Julia Angwin、Jeff Larson、Surya Mattu、Lauren Kirchner著、2016年5月23日)

(4) 誤った評価を訂正することが困難

AIの発展により、AIによるプロファイリングの利用場面は、先の事例の量刑判断や、企業の採用選考、ローンの審査など、個人の人生に大きな影響を与えうる範囲にまで広がりつつあります。

中国ではアリペイ社が、パーソナルデータに基づいて個人の信用力を査定するサービスである芝麻信用を提供していますが、利用者はこの信用スコアによって、ホテル宿泊時のデポジットが不要となる、提携する消費者金融での審査に時間がかからないといった恩恵を受けられます。また、信用スコアによって、シンガポールをはじめ一部の国へのビザ申請時に、資産証明や在職証明、戸籍証明といった書類の煩雑な準備が不要になる※5など、その影響力は公的な機関にも及んでいます。

一方で、一度なされた評価を覆すことは非常に困難で、誤って低い評価を受けてしまった場合、社会のさまざまな場面で不利益を被ることになるという問題点も指摘されています。AIによるプロファイリング結果を覆すことが困難である最大の理由は、結果が誤っていることの説明が非常に困難であるということです。AIによるプロファイリングのアルゴリズムは非常に複雑でブラックボックスであるため、どのようなプロセスを経て結果が導き出されたのかは、通常は不明です。

必ずしもプロファイリングの正確性が保証されているわけではないことは前述しましたが、自身の評価の訂正を求める正当性を示すことが困難であるということは、自己情報コントロールが欠落しているという点で、プライバシー侵害のリスクがあると言えます。

- ※5

- “ビザ申請時に「芝麻ポイント」の利用が可能に”(人民網日本語版、2015年6月8日)

(5) 非常に精巧につくられ、一見して見分けがつかない偽の情報が流通する

Deep Fakeという言葉を聞いたことがある人は多いのではないでしょうか。これは、本人が実際には話していないことを話させたり、人物の顔を巧妙に入れ替えたりして、本物のような偽動画などを作る技術ですが、AIの発展に伴って精巧さを増し、もはや一見して見分けがつかないレベルに達しています。

中国では、顔を入れ替えることで簡単にDeep Fake動画を作成できるスマートフォンアプリがリリースされています。今後ますます身近なものになっていくことが予測されますが、Deep Fakeはいくつかの点でプライバシー侵害であると言えます。第1に、顔画像などが無断で使用されることが肖像権の侵害にあたるという点です。肖像権とは、自己の容姿やその画像などをみだりに公表されたり利用されたりすることのない権利であり、プライバシー権の一部とされています。第2に、本人に関する、誤った印象を与える情報が発信される可能性があるという点です。そして第3に、Deep Fakeにより作られた動画は、一度SNS(ソーシャル・ネットワーキング・サービス)などを通して拡散されてしまうと、削除したり訂正したりすることが非常に困難であるという点です。

2. プライバシー保護に関するルール面、技術面での動向

前述したように、AIの発達に伴い、これまでにはなかったプライバシー侵害のリスクが顕在化しています。しかしAIには本来、人間の作業を代替したり、人間の能力では難しいレベルの解析をしたりするなど、さまざまな利点があります。重要なのは、AIによるプライバシー侵害のリスクを特定して、プライバシー保護のための具体的な対策によってリスクを低減し、AIの活用による便益とプライバシー保護との両立を図ることです。

もちろん、AIによるプライバシー侵害のリスクを意識し、先行的に取り組んでいる企業や団体も存在します。そこで、リスク低減に向けた取り組みをルール面、技術面に分けていくつか紹介します。

ルール面

(A)Googleの取り組み

Google社は、AIがもたらす負の側面も考慮し基本理念を定めています。2018年Googleは、武器の開発につながりかねない技術を米国国防総省に提供しようとしていたことが明らかになりました。これに対して、従業員の反対の意を示す署名や技術者の退職など社内で抗議が発生し、結果的にGoogleは国防総省とのプロジェクト契約を更新しない方針を表明※6しました。この出来事を踏まえ、同年「Google と AI : 私たちの基本理念(Artificial Intelligence at Google: Our Principles)」を策定するに至りました※7。この基本理念は、AIの開発や運用が長期にわたり社会に影響を与えるという認識のもと、研究や製品開発、事業判断をする上でのGoogleとしての具体的な考え方を示すことを目的に策定されています。以下に示す7つの基本方針と、AIを設計および提供しないとする4分野※8の説明を中心に構成されています。

- ① 社会にとって有益である(Be socially beneficial.)

- ② 不公平なバイアスの発生、助長を防ぐ(Avoid creating or reinforcing unfair bias.)

- ③ 安全性確保を念頭に置いた開発と試験(Be built and tested for safety.)

- ④ 人々への説明責任(Be accountable to people.)

- ⑤ プライバシー・デザイン原則の適用(Incorporate privacy design principles.)

- ⑥ 科学的卓越性の探求(Uphold high standards of scientific excellence.)

- ⑦ これらの基本理念に沿った利用への技術提供(Be made available for uses that accord with these principles.)

- ※6

- CNN.co.jp「グーグル、国防総省との契約更新せず ドローン技術で」

- ※7

- (英) Our Principles - Google AI

(日) Google Japan Blog: Google と AI : 私たちの基本理念 - ※8

- 人々に危害を与える武器に関する技術、監視(国際的に認められた規範に反するもの)を目的とした技術などが該当する。

基本方針では「プライバシー・デザイン原則の適用」とあるように、プライバシーの保護を念頭に掲げており、AIシステムの開発において、ユーザーから収集するデータの内容と目的を明確にすること、ユーザー自身がデータを確認、移動、削除できることを示した「プライバシー原則」を適用するとしています。加えて「人々への説明責任」においては、AIシステムの設計に際し、フィードバックや説明を求めたり、異議を申し立てたりする機会を適切に確保することも示されています。

またGoogleは、AIの開発場面において留意すべきことをより詳細に定め、プライバシー保護の実効性を高めています。それが“People + AI Guidebook”です※9。このガイドブックは2019年に公開されたもので、UX(ユーザーエクスペリエンス)の設計に従事する者やプロダクトマネジャー向けに、人間中心のAIソリューションを作るための考え方や留意事項を整理したものです。本文は、以下の6つの章より構成されています。

- User Needs + Defining Success:ユーザーのニーズと、それに対するAIの適用場面の設定と、インセンティブを与えるための報酬関数の定義についての解説。

- Data Collection + Evaluation:ユーザーのニーズを満たすために必要なデータ項目の決定と、AIのチューニングについての解説。

- Mental Models: AIの学習のさせ方をユーザーに対して説明する際の内容や方法についての解説。

- Explainability + Trust:AIが導き出す結果に対し、その理由や信頼性についての説明内容についての解説。

- Feedback + Control:AIの能力やUXを向上させるための、AIへのフィードバックや、人間によるコントロールの仕組みの設計についての解説。

- Errors + Graceful Failure:AIが導き出す結果に対し、エラーであると判断するための方法や、原因の特定の仕方についての解説。

先にプライバシー侵害のリスクを5つ挙げましたが、このガイドブックにおいても、それらのリスク低減のために取るべき具体的な行動が示されています。そのうち、ここでは2つ紹介します。

まず、プロファイリングの正確性に保証がないというリスクについては、“Data Collection + Evaluation”の項目の記述が参考になります。この項目では、AI開発のあらゆる過程で、人間のバイアスが機械学習に入り込む可能性を指摘しています。その上で、学習対象のデータセットに対してFacets※10のようなツールを用いて、多様性や文化的背景が考慮されているかどうかの確認や、教師データ作成の際における評価者集団の多様性の確保、評価者自身に対する偏見を認識させるための教育といった対処方法を提示しています。これらにより、学習データが適切であるかどうかをチェックでき、学習させる立場である人間もまた、自身に内在するバイアスを意識するようになります。このような対策を行うことでプロファイリングの正確性を高めることにより、本人に関して誤った印象を与えてしまうといったプライバシー侵害のリスク低減が期待できます。

次に、個人に対してなされた誤った評価を訂正することが困難であるというプライバシー侵害のリスクについては、“Explainability + Trust”の項目の記述が参考になります。この項目では、植物の種類を推測するアプリケーションを例に、AIが示した判断の理由を分かりやすく説明する方法を挙げています。例えば、ある植物が「毒うるし」であると推測した理由として「○○という特徴があるから、恐らく毒うるしである」「裂片が5つでないからもみじではない」のような説明であれば、理由が特定でき、分かりやすくなります。これに対し「植物の色、葉の形、その他要素で判断する」という理由のみでは、分かりやすさに欠けます。この事例では、プライバシーを考慮する必要のない植物が対象となっていることに注意が必要ですが、適切な説明の仕方を示す好例であるため紹介しました。このように判断理由を分かりやすく示すことで、プロファイリングをされた人はその根拠を知り、誤りがあれば訂正を求めやすくなることから、プライバシー侵害のリスクを低減できると考えられます。

- ※10

- Googleが提供する、オープンソースの可視化ツール。

(B) Twitterの取り組み

Deep Fakeへの対策を考える上で、Twitterの「合成または操作されたメディアに関するポリシー※11」は注目すべきルールであると言えます。このポリシーは、意図的にねつ造された可能性のある画像などが含まれるツイートを特定し、Twitterの利用者が当該情報の信ぴょう性を確認することの支援を目的として、2020年に公表されました。あるツイートに含まれる動画、音声、画像などのメディアについて、利用者を欺くことを意図した改ざんやねつ造がなされているか、利用者を欺く意図で共有されているか、公共の安全に影響を及ぼしたり深刻な損害をもたらしたりする可能性が高いかという3つの基準で判定し、1つでも当てはまると判断されればラベル付けされ、複数当てはまる場合には削除される可能性があるとしています。Twitterのこのようなポリシーの運用により、SNSにおいてDeep Fakeを削減することが期待でき、肖像権の侵害や、本人に関する事実と異なる情報の拡散といったプライバシー侵害のリスクも低減できる可能性があります。

技術面

(A)XAI

個人に対してなされた誤った評価を訂正することが困難であるというプライバシー侵害については、そのリスク低減に資する技術として、XAI(Explainable Artificial Intelligence)すなわち「説明できるAI」があります。AIに大量のデータを学習させるディープラーニングでは、AIがある問いに対して判断結果を提示しますが、そのアルゴリズムはブラックボックスです。そのため、AIが判断結果をどのような理由で導き出したかを示すのは困難ですが、それを解決するのがXAIです。例えば、ある人が銀行に融資を申し込んだ結果、AIが謝絶の判断をしたとします。行員がその人に対して謝絶の旨を伝えるのみでは、申し込んだ人は納得しません。しかし「希望した金額と返済計画に対して、あなたの収入が低いこと、会社員としての年数が短いことが理由で謝絶となった」というような根拠を示すことで納得感を得られ、申し込んだ人にとってもその後の対応が考えやすくなります。XAIは、株式会社 日立製作所や富士通株式会社、米国国防総省の研究機関である国防高等研究計画局などが開発を進めています。XAIにより、AIの判断理由が分かりやすくなり、個人が誤った判断を下された場合に訂正を求めやすくなることから、プライバシー侵害のリスク低減に資する技術のひとつと言えます。

(B)Deepfake Detection Challenge

Deep Fakeによるプライバシー侵害を防ぐため、Deep Fake検出技術の向上への取り組みも行われています。例えばDeepfake Detection Challengeは、Deep Fakeにより生成された偽の画像をAIで検出する技術を誰もが使えるようにすることを目的とし、2019年12月から2020年3月まで、AWS、Facebook、Microsoft、米国を拠点とするAIの研究団体Partnership on AIの主催で開催されました※12。主催者は、本人から同意を得て取得した俳優らの人物画像と、Deep Fakeにより生成された偽の画像を準備し、参加者はそれを入手し学習させてAIを開発します。参加者は開発したAIのコードを主催者の検証環境に送付して、Deep Fakeの検出技術の有効性評価を受けます。評価の結果、優れた技術に対しては最高で50万米ドルの賞金が与えられました。Facebookはおよそ1,000万米ドルの資金を拠出するなどして注力しており、ソーシャルメディアにおいて、Deep Fakeの検出技術の向上が重要な課題であることがうかがえます。このような取り組みを通して、技術的な面からもDeep Fakeによるプライバシー侵害を防いでいくことが期待できます。

おわりに

本稿では、AIが引き起こすリスクを整理し、それらのリスク低減に資するルール面、技術面での取り組みを紹介しました。AIに関わるプライバシー侵害のリスクを低減するためには、まずはAIの活用を検討する段階において、発生すると考えられるプライバシー侵害を特定し対処していくことが求められます。今後もこのような取り組みが深化し、プライバシーを保護しつつ、AIの利用が進んでいくことを期待します。

※記載内容(所属部署・役職を含む)は制作当時のものです。